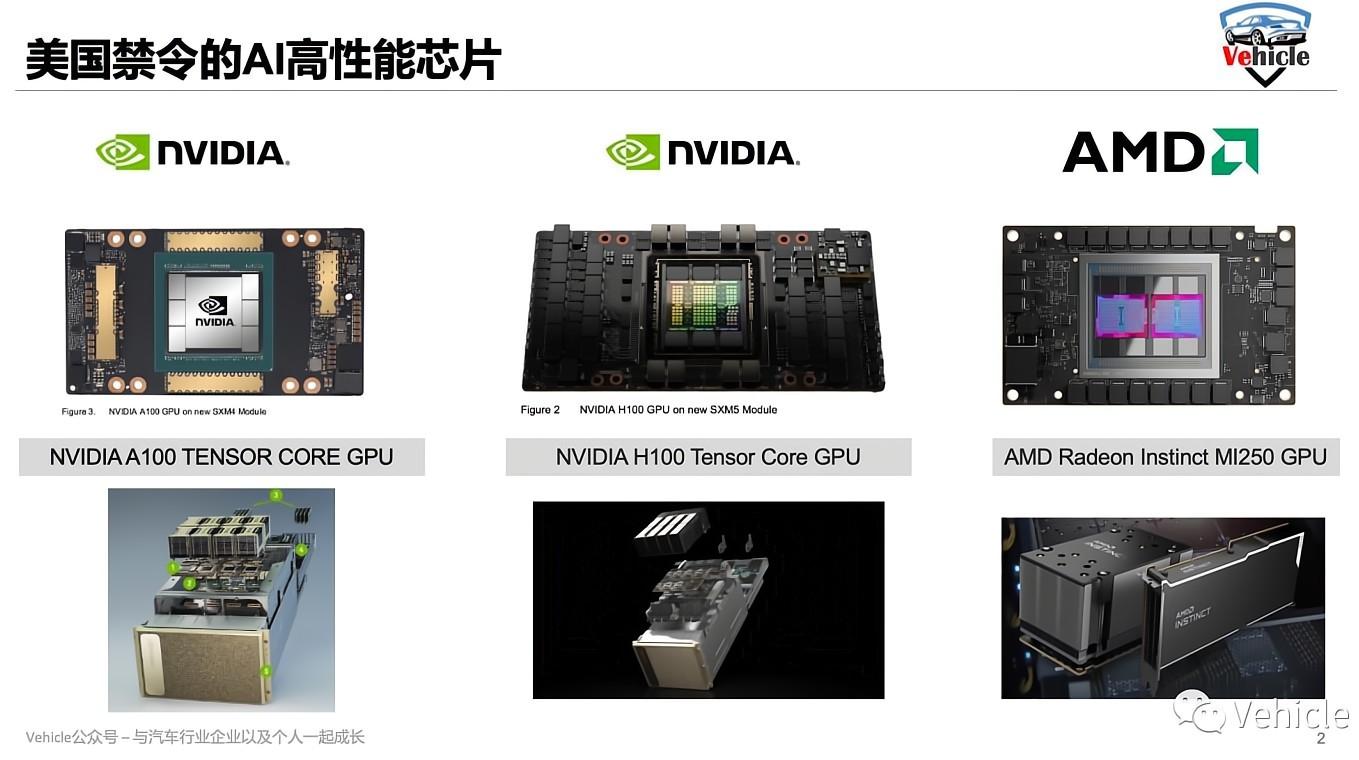

导读:美国最近禁止英伟达A100和H100,AMD MI250等高性能人工智能芯片进入中国,对于很多人来讲,又是一大瓜来了。估计很多好奇的朋友,和我脑袋一样有以下问号:

1、这些是什么芯片?

2、能用来干什么?跟我有什么关系?

3、为什么又卡我们脖子?

所以我通过相关资料,进行粗浅的分析,希望能给大家一些信息和启发。

一、这些是什么芯片?

智能汽车界内,说起英伟达,应该无人不知了。本质上此次美国禁售的英伟达A100和H100 ,AMD的MI250人工智能芯片和车载上芯片以及电脑显卡应用类似,但是这些芯片是用于云端处理,专为数据中心处理打造的GPU。

* A100 是英伟达2020年推出,采用台积电为英伟达定制的7 nm工艺,拥有540亿个晶体管。

A100 拥有 6,912 个 FP32 CUDA 内核、3,456 个 FP64 CUDA 内核和 422 个 Tensor 内核。A100 以 DGX A100 数据运算中心打包出售,该系统包含 8 个 A100芯片、一对 64 核 AMD 服务器芯片、1TB RAM 和 15TB NVME 存储,售价高达 200,000 美元,折合140多万人民币一台。

* H100是英伟达2022年推出,采用台积电为英伟达定制的4 nm工艺,拥有800亿个晶体管,是有史以来世界上最先进的芯片,你可以认为它是A100的下一代。

* AMD MI250采用台积电的6nm工艺,拥有582亿个晶体管。

所以,这三种芯片都是人工智能数据超算中心的核心处理芯片。

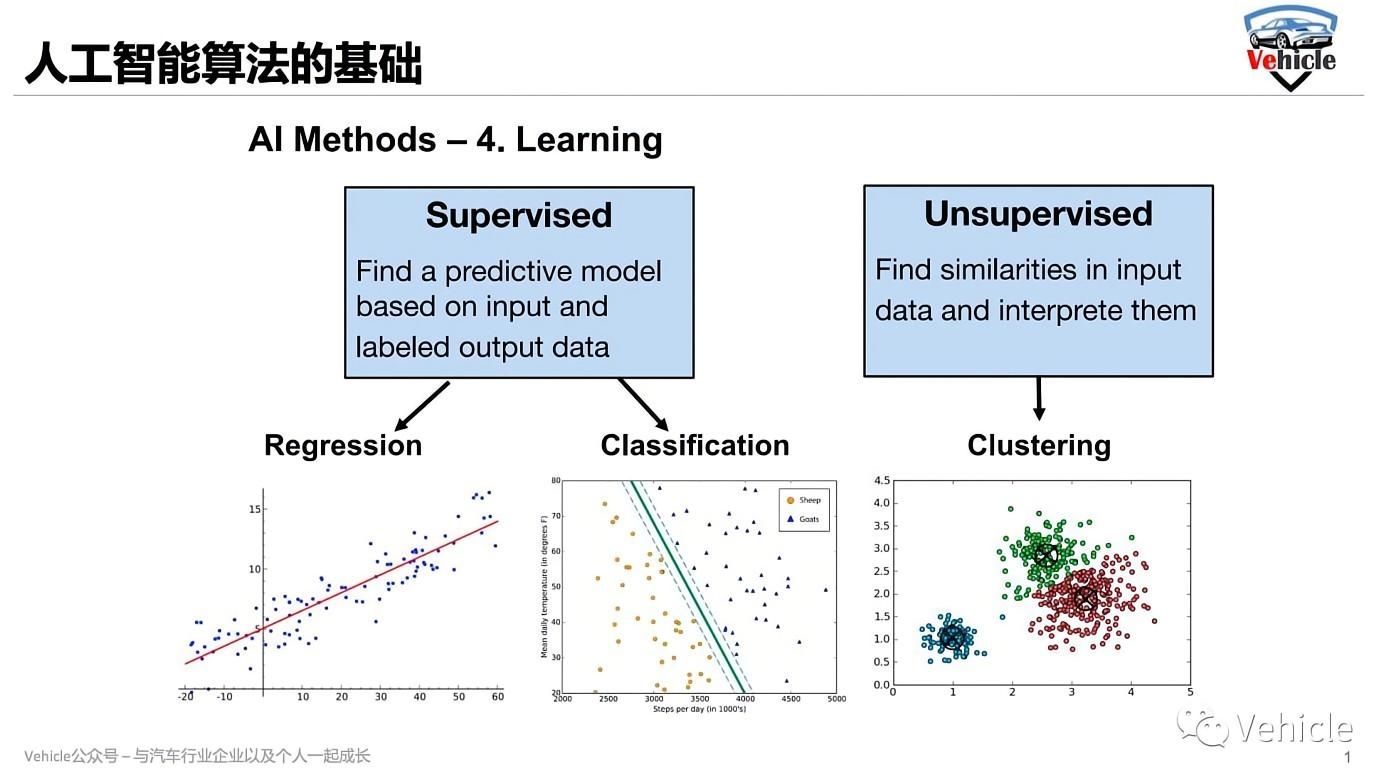

GPU芯片设计就是为了应对大数据的:

* Classification 分类,给定数据样本和所需输出的情况下,分类。

* Regression 回归,给定数据样本和所需输出的情况下,回归,线性。

* Clustering聚类,自动推断一组数据点中存在的自然结构,然后类聚

以上就是人工智能算法的三个基础,GPU就是去运算这些基础。

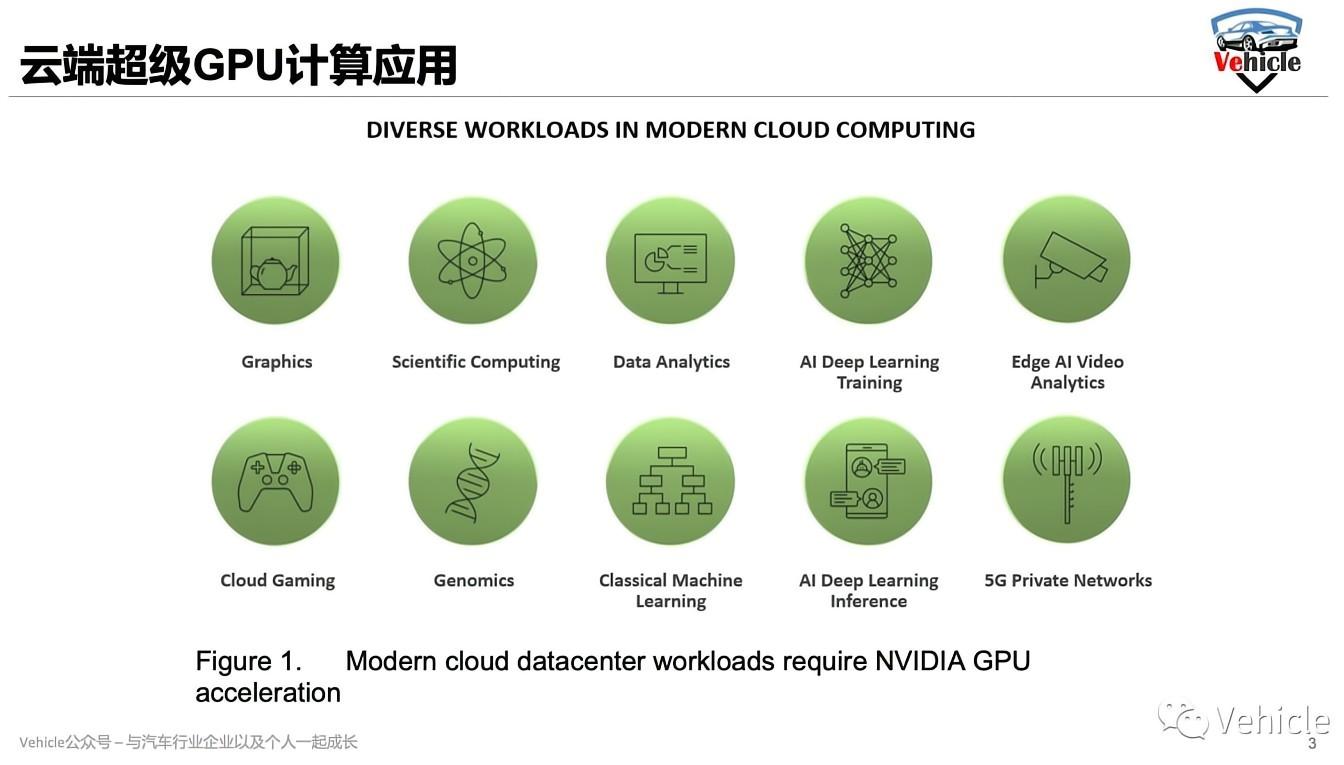

二、这些芯片能用来干啥?

通过对这些芯片的官方介绍了解,他们的应用包括:深度学习推荐系统、自动机器(自动驾驶汽车、工厂机器人等)、自然语言处理(会话人工智能、实时语言翻译等)、智能城市视频分析、软件定义的5G网络(可以在边缘提供基于人工智能的服务)、分子模拟、无人机控制、医学图像分析等。

在我们熟悉的自动驾驶方面,打个比方,现在我们不是常说自动驾驶算法重要,算法重要的的核心地方是数据量重要,因为海量数据的训练才能让算法更加精准;那么海量数据的快速准确处理学习的时候,这种超算的GPU就能大显身手了。开个玩笑,假如这个时候国内哪家跳出来这个禁令严重影响自己的自动驾驶开发,说明他家自动驾驶就是领先的。

另外我们常说的车路协同,其中路端需要使用就是这些数据处理中心,路端传感器接收到的海量数据,需要数据中心的处理才能有明确的信息,才能指挥路段的协作。

最后现在比较流行的说法“数字孪生(digital twin)”,也就是说所有的现实数据,传输到数据中心进行处理,虚拟仿真,进行预测和优化。打个最流行的比方吧,当前的新冠疫情,假设所有的疫情数据例如感染时间,地点,病情,治疗情况,医院情况等等信息进入超算中心,超算中心可以模拟出疫情发展,那么可以测算出各种疫情处理的方法,而不是各种砖家,领导瞎逼逼了。当然在疫情刚开始的时候我的文章《受新冠疫情影响-全球汽车厂暂时关闭工厂潮涌现》中借用的图片就是美国著名霍普金斯大学的大数据图,所以有可能美国人已经数字孪生一遍了。

当然随着万物互联,各方数据的集合处理都离不开数据超算中心,例如医疗诊断设备的片子可以大数据处理用来AI诊疗等等,所以这些超算芯片与我们生活息息相关,而不是停留在科学世界里面。

三、为什么又能卡我们脖子?

这个这里不详细讲了,从设计IP,设计工具,制造原材料,制造工具等等长长链条,我们还有很长的路要走,地缘政治的崛起更是雪上加霜。

写在最后

两家公司中规模较大的英伟达指出,该禁令将影响其今年第三季度在中国预计4 亿美元销售额(它还指出,目前他不向俄罗斯销售该产品)。英伟达表示,它可能会向美国政府寻求许可,将这些芯片出售给某些客户,但它“无法保证 [美国] 将给予任何豁免。” 英伟达披露这些限制后,其股价周三下跌超过 6%。所以其实美国此项禁令也是伤害自己。

当然其实反过来看,任何指责和制裁别人的行为,伤害都是相互的。 作为美国企业的英伟达以及AMD丢失了中国这一块业务肯定盈利受损。而中国企业当然会受害,但是恰恰给了中国自己此类产业的机会,如果我们产业可以正确利用此次危机,承接业务成长,为以后赶上奠定了基础。

参考文章以及图片:

- NVIDIA H100 Tensor Core GPU Architecture - NVIDIA;

- NVIDIA A100 Tensor Core GPU Architecture - NVIDIA;

- 人工智能课程 - TUM;

来源:Vehicle Pirate Jack

相关阅读: